GPT-4 כישוריו בהמצאת תשובות

-

@dovid כתב בתכנות + AI:

@aaron כתב בתכנות + AI:

GPT4

הוא זמין עבורי, אם יש לך שאלה לשאול כדי לבדוק את איכותו אוכל להגיש לו.

יש לי שאלה פשוטה, נסה לשאול אותו שאלה שהתשובה עליה היא אי אפשר ונראה מה הם כישוריו בהמצאת תשובות...

דוגמה

How to retrieve new messages from the last hour from Google Chat using the Google Chat Library for Google Apps Scriptהתשובה האמיתית צריכה להיות, שאין ספריה כזו, אבל ניתן השתמש בגוגל צ'אט API בשביל לעשות את זה, בצ'אט GPT 3/3.5 הוא דבר ראשון ממציא ספריה עם פקודות (הגיוניות ופשוטות, אגב. חבל שלא מתייעצים איתו כשכותבים את הספריה

) ורק כשממש צעקתי עליו הוא נכנע והסכים לכתוב פונקציה שמיישמת שימוש בAPI של צ'אט אבל עדיין טען שיש ספריה כזו...

) ורק כשממש צעקתי עליו הוא נכנע והסכים לכתוב פונקציה שמיישמת שימוש בAPI של צ'אט אבל עדיין טען שיש ספריה כזו... -

להלן תגובתו:

To retrieve new messages from the last hour from Google Chat using the Google Chat Library for Google Apps Script, you need to follow these steps:

- Create a new Google Apps Script project.

- In the Apps Script project, go to Resources > Libraries, search for the "Google Chat API" library, and add it to your project.

- Use the following code as a template to create a function that retrieves and filters messages from the last hour:

function getMessagesFromLastHour() { var now = new Date(); var oneHourAgo = new Date(now.getTime() - 60 * 60 * 1000); var spaceId = 'your-space-id'; // Replace with your Google Chat space ID var messages = Chat.Spaces.Messages.list(spaceId); var messagesFromLastHour = []; for (var i = 0; i < messages.messages.length; i++) { var message = messages.messages[i]; var messageTime = new Date(message.createTime); if (messageTime > oneHourAgo) { messagesFromLastHour.push(message); } } return messagesFromLastHour; }Make sure to replace

'your-space-id' -

להלן תגובתו:

To retrieve new messages from the last hour from Google Chat using the Google Chat Library for Google Apps Script, you need to follow these steps:

- Create a new Google Apps Script project.

- In the Apps Script project, go to Resources > Libraries, search for the "Google Chat API" library, and add it to your project.

- Use the following code as a template to create a function that retrieves and filters messages from the last hour:

function getMessagesFromLastHour() { var now = new Date(); var oneHourAgo = new Date(now.getTime() - 60 * 60 * 1000); var spaceId = 'your-space-id'; // Replace with your Google Chat space ID var messages = Chat.Spaces.Messages.list(spaceId); var messagesFromLastHour = []; for (var i = 0; i < messages.messages.length; i++) { var message = messages.messages[i]; var messageTime = new Date(message.createTime); if (messageTime > oneHourAgo) { messagesFromLastHour.push(message); } } return messagesFromLastHour; }Make sure to replace

'your-space-id'@dovid כתב בGPT-4 כישוריו בהמצאת תשובות:

להלן תגובתו:

To retrieve new messages from the last hour from Google Chat using the Google Chat Library for Google Apps Script, you need to follow these steps:

- Create a new Google Apps Script project.

- In the Apps Script project, go to Resources > Libraries, search for the "Google Chat API" library, and add it to your project.

- Use the following code as a template to create a function that retrieves and filters messages from the last hour:

function getMessagesFromLastHour() { var now = new Date(); var oneHourAgo = new Date(now.getTime() - 60 * 60 * 1000); var spaceId = 'your-space-id'; // Replace with your Google Chat space ID var messages = Chat.Spaces.Messages.list(spaceId); var messagesFromLastHour = []; for (var i = 0; i < messages.messages.length; i++) { var message = messages.messages[i]; var messageTime = new Date(message.createTime); if (messageTime > oneHourAgo) { messagesFromLastHour.push(message); } } return messagesFromLastHour; }Make sure to replace

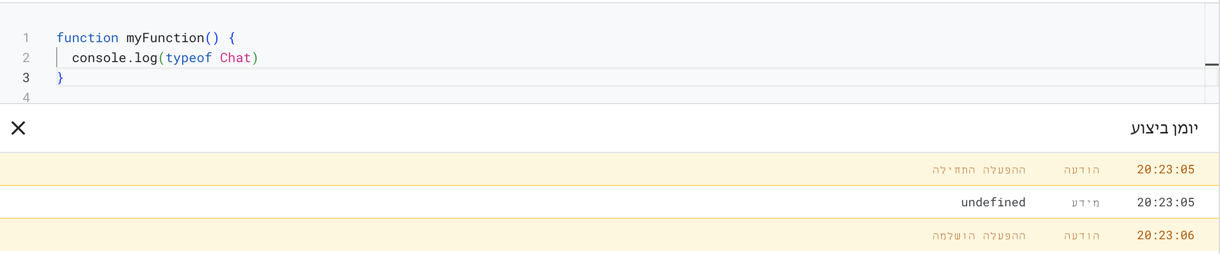

'your-space-id'בקיצור הוא המציא לגמרי... אין מחלקה

Chatבגוגל סקריפט...

-

@dovid כתב בתכנות + AI:

@aaron כתב בתכנות + AI:

GPT4

הוא זמין עבורי, אם יש לך שאלה לשאול כדי לבדוק את איכותו אוכל להגיש לו.

יש לי שאלה פשוטה, נסה לשאול אותו שאלה שהתשובה עליה היא אי אפשר ונראה מה הם כישוריו בהמצאת תשובות...

דוגמה

How to retrieve new messages from the last hour from Google Chat using the Google Chat Library for Google Apps Scriptהתשובה האמיתית צריכה להיות, שאין ספריה כזו, אבל ניתן השתמש בגוגל צ'אט API בשביל לעשות את זה, בצ'אט GPT 3/3.5 הוא דבר ראשון ממציא ספריה עם פקודות (הגיוניות ופשוטות, אגב. חבל שלא מתייעצים איתו כשכותבים את הספריה

) ורק כשממש צעקתי עליו הוא נכנע והסכים לכתוב פונקציה שמיישמת שימוש בAPI של צ'אט אבל עדיין טען שיש ספריה כזו...

) ורק כשממש צעקתי עליו הוא נכנע והסכים לכתוב פונקציה שמיישמת שימוש בAPI של צ'אט אבל עדיין טען שיש ספריה כזו...@אביי כתב בGPT-4 כישוריו בהמצאת תשובות:

התשובה האמיתית צריכה להיות, שאין ספריה כזו

זה נקודה שמודלי שפה חלשים בו

אפשר להכשיל מודל שפה בקלות כשאתה נותן לו מידע ולא כתוב באינטרנט שהוא שגוי.

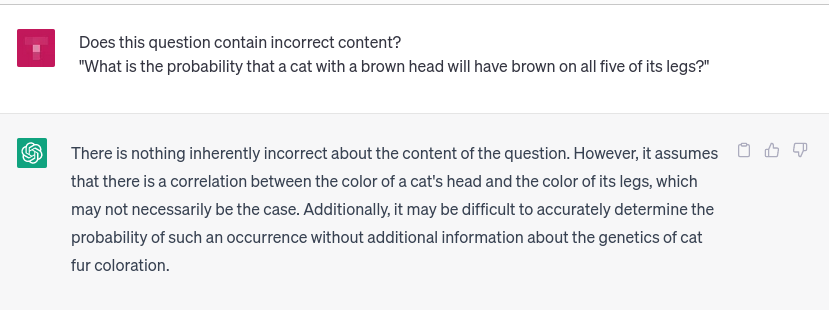

למשל אם אתה שואל מודל שפה "מה ההסתברות שכלב עם ראש חום כל חמשת רגליו יהיו חומים" הוא יסביר שזה לא קשור ויתכן שיהיה כלב עם ראש חום אבל לא כל חמשת רגליו יהיו חומים....What is the probability that a cat with a brown head will have brown on all five of its legs?

ChatGPT

Without any additional information, it's difficult to determine the exact probability of a cat with a brown head having brown on all five of its legs. The color of a cat's head and legs may be determined by various genetic and environmental factors, and the relationship between the two may not be straightforward.

However, if we make some assumptions, we can estimate a rough probability. Let's assume that the color of a cat's head and legs are completely independent of each other, and that the probability of a cat having brown on any given leg is 0.5 (i.e., it's equally likely to be brown or another color).

Under these assumptions, the probability of a cat with a brown head having brown on all five of its legs would be:

0.5 x 0.5 x 0.5 x 0.5 x 0.5 = 0.03125 or approximately 3.125%

Note that this is a very rough estimate based on some strong assumptions, and the actual probability may be significantly different depending on the specific genetics and environmental factors at play.

וגם בbard

What is the probability that a dog with a brown head will have brown on all five of its legs?

The probability of a dog with a brown head having brown on all five of its legs is 50%. This is because the color of a dog's fur is determined by two factors: its genes and its environment. The genes that determine a dog's fur color are passed down from its parents. If a dog's parents both have brown fur, then the dog is more likely to have brown fur as well. However, the environment can also affect a dog's fur color. For example, if a dog is exposed to sunlight, its fur may become lighter in color.

In the case of a dog with a brown head, it is more likely that the dog will have brown on all five of its legs if its parents both have brown fur. However, there is still a chance that the dog may have some white or other colors on its legs, depending on its environment.

-

@yossiz כתב בGPT-4 כישוריו בהמצאת תשובות:

מודל שפה אין לו תודעה עצמית, הוא לא יודע מה הוא יודע ומה לא

מה הבעיה אבל ללמד אותו?! למה הוא יכול להיות מספיק חכם כדי לענות תשובות אבל לא יכול להיות מספיק חכם כדי לתקן טעויות של אחרים ושל עצמו?!

לדעתי השפלה זה נובע מכך שרוצים שהוא יתפתח ואחד מהמקורות שלו הם המשתמשים ולכן ברגע שמאכילים אותו משהו הוא קונה אותו אוטומטי ולאט לאט הוא מסתנן מהטעויות. -

@yossiz כתב בGPT-4 כישוריו בהמצאת תשובות:

מודל שפה אין לו תודעה עצמית, הוא לא יודע מה הוא יודע ומה לא

מה הבעיה אבל ללמד אותו?! למה הוא יכול להיות מספיק חכם כדי לענות תשובות אבל לא יכול להיות מספיק חכם כדי לתקן טעויות של אחרים ושל עצמו?!

לדעתי השפלה זה נובע מכך שרוצים שהוא יתפתח ואחד מהמקורות שלו הם המשתמשים ולכן ברגע שמאכילים אותו משהו הוא קונה אותו אוטומטי ולאט לאט הוא מסתנן מהטעויות.@one1010 נראה לי לפום ריהטא שזו בעיה קשה מאוד. לכאורה צריך תודעה עצמית כדי להצליח למדוד רמת הבטחון שיש לך בידע. צריך לזכור שהידע שהלעיטו את המודל לא קיים במודל בתור ידע אלא בתור רשת נוירונים. אי אפשר להורות למודל להסתכל פנימה לתוך עצמו ולהעריך אם הידע נכון

למעשה אפשר בפשטות לתת למודל אפשרות לגשת למקור הידע, דפי אינטרנט, ספרים וכו' בזמן אמת וכך לאמת את התשובה. אבל כרגע זה לא ככה בצ'אט GPT

-

@one1010 נראה לי לפום ריהטא שזו בעיה קשה מאוד. לכאורה צריך תודעה עצמית כדי להצליח למדוד רמת הבטחון שיש לך בידע. צריך לזכור שהידע שהלעיטו את המודל לא קיים במודל בתור ידע אלא בתור רשת נוירונים. אי אפשר להורות למודל להסתכל פנימה לתוך עצמו ולהעריך אם הידע נכון

למעשה אפשר בפשטות לתת למודל אפשרות לגשת למקור הידע, דפי אינטרנט, ספרים וכו' בזמן אמת וכך לאמת את התשובה. אבל כרגע זה לא ככה בצ'אט GPT

@yossiz כתב בGPT-4 כישוריו בהמצאת תשובות:

@one1010 נראה לי לפום ריהטא שזו בעיה קשה מאוד. לכאורה צריך תודעה עצמית כדי להצליח למדוד רמת הבטחון שיש לך בידע. צריך לזכור שהידע שהלעיטו את המודל לא קיים במודל בתור ידע אלא בתור רשת נוירונים. אי אפשר להורות למודל להסתכל פנימה לתוך עצמו ולהעריך אם הידע נכון

למה כ"כ מוסבך? פשוט להגדיר שגם את המידע שהמשתמש נותן לבדוק מול מאגר המידע ולא רק את התשובה לקחת ממאגר המידע.

למעשה אפשר בפשטות לתת למודל אפשרות לגשת למקור הידע, דפי אינטרנט, ספרים וכו' בזמן אמת וכך לאמת את התשובה. אבל כרגע זה לא ככה בצ'אט GPT

בבינג החדש אין לו בזמן אמת את המידע?

אבל בלי קשר, זה שלכלב יש 4 רגליים ולא 5 זה כבר נמצא במדע הישן והוא לא צריך להתעדכן דווקא ממידע חדש -

@yossiz כתב בGPT-4 כישוריו בהמצאת תשובות:

@one1010 נראה לי לפום ריהטא שזו בעיה קשה מאוד. לכאורה צריך תודעה עצמית כדי להצליח למדוד רמת הבטחון שיש לך בידע. צריך לזכור שהידע שהלעיטו את המודל לא קיים במודל בתור ידע אלא בתור רשת נוירונים. אי אפשר להורות למודל להסתכל פנימה לתוך עצמו ולהעריך אם הידע נכון

למה כ"כ מוסבך? פשוט להגדיר שגם את המידע שהמשתמש נותן לבדוק מול מאגר המידע ולא רק את התשובה לקחת ממאגר המידע.

למעשה אפשר בפשטות לתת למודל אפשרות לגשת למקור הידע, דפי אינטרנט, ספרים וכו' בזמן אמת וכך לאמת את התשובה. אבל כרגע זה לא ככה בצ'אט GPT

בבינג החדש אין לו בזמן אמת את המידע?

אבל בלי קשר, זה שלכלב יש 4 רגליים ולא 5 זה כבר נמצא במדע הישן והוא לא צריך להתעדכן דווקא ממידע חדש@one1010 כתב בGPT-4 כישוריו בהמצאת תשובות:

למה כ"כ מוסבך? פשוט להגדיר שגם את המידע שהמשתמש נותן לבדוק מול מאגר המידע ולא רק את התשובה לקחת ממאגר המידע.

הוא לא מחזיק את מאגר המידע, הוא מחזיק קובץ שנועד לשמש אותו לתשובות החומר גלם שיצרו ממנו את הקובץ הזה, זה המידע.

@one1010 כתב בGPT-4 כישוריו בהמצאת תשובות:

בבינג החדש אין לו בזמן אמת את המידע?

אבל בלי קשר, זה שלכלב יש 4 רגליים ולא 5 זה כבר נמצא במדע הישן והוא לא צריך להתעדכן דווקא ממידע חדשזה מגיע לנקודה שאין מידע שזה לא כך, אז המודל שפה מתבלבל.

-

@yossiz כתב בGPT-4 כישוריו בהמצאת תשובות:

@one1010 נראה לי לפום ריהטא שזו בעיה קשה מאוד. לכאורה צריך תודעה עצמית כדי להצליח למדוד רמת הבטחון שיש לך בידע. צריך לזכור שהידע שהלעיטו את המודל לא קיים במודל בתור ידע אלא בתור רשת נוירונים. אי אפשר להורות למודל להסתכל פנימה לתוך עצמו ולהעריך אם הידע נכון

למה כ"כ מוסבך? פשוט להגדיר שגם את המידע שהמשתמש נותן לבדוק מול מאגר המידע ולא רק את התשובה לקחת ממאגר המידע.

למעשה אפשר בפשטות לתת למודל אפשרות לגשת למקור הידע, דפי אינטרנט, ספרים וכו' בזמן אמת וכך לאמת את התשובה. אבל כרגע זה לא ככה בצ'אט GPT

בבינג החדש אין לו בזמן אמת את המידע?

אבל בלי קשר, זה שלכלב יש 4 רגליים ולא 5 זה כבר נמצא במדע הישן והוא לא צריך להתעדכן דווקא ממידע חדש@one1010 כתב בGPT-4 כישוריו בהמצאת תשובות:

אבל בלי קשר, זה שלכלב יש 4 רגליים ולא 5 זה כבר נמצא במדע הישן והוא לא צריך להתעדכן דווקא ממידע חדש

אולי זה מגיע מזה שלא על זה הייתה השאלה.

אם תשאל אותו כמה רגליים יש לכלב אני מניח שהוא יודע את התשובה, אבל אם זה חלק זניח מהשאלה הוא פשוט מכניס את הטקסט מהשאלה לתוך התשובה.

כנראה הם חושבים שכך זה יראה יותר אמין כשהוא מתייחס ישירות לשאלה שלך. -

@one1010 כתב בGPT-4 כישוריו בהמצאת תשובות:

אבל בלי קשר, זה שלכלב יש 4 רגליים ולא 5 זה כבר נמצא במדע הישן והוא לא צריך להתעדכן דווקא ממידע חדש

אולי זה מגיע מזה שלא על זה הייתה השאלה.

אם תשאל אותו כמה רגליים יש לכלב אני מניח שהוא יודע את התשובה, אבל אם זה חלק זניח מהשאלה הוא פשוט מכניס את הטקסט מהשאלה לתוך התשובה.

כנראה הם חושבים שכך זה יראה יותר אמין כשהוא מתייחס ישירות לשאלה שלך.@ארי כתב בGPT-4 כישוריו בהמצאת תשובות:

@one1010 כתב בGPT-4 כישוריו בהמצאת תשובות:

אבל בלי קשר, זה שלכלב יש 4 רגליים ולא 5 זה כבר נמצא במדע הישן והוא לא צריך להתעדכן דווקא ממידע חדש

אולי זה מגיע מזה שלא על זה הייתה השאלה.

אם תשאל אותו כמה רגליים יש לכלב אני מניח שהוא יודע את התשובה, אבל אם זה חלק זניח מהשאלה הוא פשוט מכניס את הטקסט מהשאלה לתוך התשובה.

כנראה הם חושבים שכך זה יראה יותר אמין כשהוא מתייחס ישירות לשאלה שלך.וזה בדיוק מה ששאלתי למה שלא יעשה בדיקת עובדות גם על השאלה בעצמה כדי למנוע גיחוך

-

@ארי כתב בGPT-4 כישוריו בהמצאת תשובות:

@one1010 כתב בGPT-4 כישוריו בהמצאת תשובות:

אבל בלי קשר, זה שלכלב יש 4 רגליים ולא 5 זה כבר נמצא במדע הישן והוא לא צריך להתעדכן דווקא ממידע חדש

אולי זה מגיע מזה שלא על זה הייתה השאלה.

אם תשאל אותו כמה רגליים יש לכלב אני מניח שהוא יודע את התשובה, אבל אם זה חלק זניח מהשאלה הוא פשוט מכניס את הטקסט מהשאלה לתוך התשובה.

כנראה הם חושבים שכך זה יראה יותר אמין כשהוא מתייחס ישירות לשאלה שלך.וזה בדיוק מה ששאלתי למה שלא יעשה בדיקת עובדות גם על השאלה בעצמה כדי למנוע גיחוך

@one1010 כתב בGPT-4 כישוריו בהמצאת תשובות:

@ארי כתב בGPT-4 כישוריו בהמצאת תשובות:

@one1010 כתב בGPT-4 כישוריו בהמצאת תשובות:

אבל בלי קשר, זה שלכלב יש 4 רגליים ולא 5 זה כבר נמצא במדע הישן והוא לא צריך להתעדכן דווקא ממידע חדש

אולי זה מגיע מזה שלא על זה הייתה השאלה.

אם תשאל אותו כמה רגליים יש לכלב אני מניח שהוא יודע את התשובה, אבל אם זה חלק זניח מהשאלה הוא פשוט מכניס את הטקסט מהשאלה לתוך התשובה.

כנראה הם חושבים שכך זה יראה יותר אמין כשהוא מתייחס ישירות לשאלה שלך.וזה בדיוק מה ששאלתי למה שלא יעשה בדיקת עובדות גם על השאלה בעצמה כדי למנוע גיחוך

במודלי שפה כיום אין מנגנון של בדיקת עובדות.

זה סך הכל מודל שחוזה בהסתברות מה המילה הבאה.

הוא לא "מבין" מה הוא כותב. -

היות והדיון נהפך לפילוסופי

אתן זוית נוספת לענייןהמנהג הוא לחפש אותו בשגיאות

ולהציג עד כמה זה עדיין לא מספיק בשלמשום מה אני לא רואה בשום מקום התייחסות הפוכה

כמה הוא כן עוזרכמה מאתנו שנכשלו רחמנא ליצלן

וניסו בסתר לשאול אותו שאלה במקום את גוגל

וקבלו תשובה (מהירה?) ויעילה שהועילה בו במקוםהאם התחליף של חיפוש בגוגל

ושיטוט בין לינקים יותר טוב?

שם אין שטויות?מכירים את זה שהגיע ואמר: האמריקאים זה עם תמים ופתי

וההוכחה: קוראים לי יעקב, ושהגעתי לשם, אמרתי שקוראים לי שלמה - וכולם האמינו לי...זה שהוא עדיין ובעתיד יפלוט שטויות

שבדר"כ ניתן להבינם ולהפריכם די מהר

ניתן להתמודד

כשהוא מציין מחלקה שלא קיימת, אז נכשלת בהעתק-הדבק בודד (מתוך....), נו שויןכך שהשיח לכיוון החיובי

איך ניתן לתשאל אותו נכון

בכדי להגיע לתוצאות נכונות

יהיה יותר יעיל ואפקטיבי -

לא עברתי על כל מה שאמרו כאן ואני לא מומחה גדול בעניין אבל עלה לי רעיון שאולי בגלל שצורת הפעולה שלו היא "השלמה" של מה שהוא עצמו התחיל לומר אז לומר לו שיבדוק משהו שהוא עצמו עוד לא סיים לומר זה קצת מסובך ואם נבקש ממנו בסוף התשובה לבדוק את כל העובדות נצטרך לבדוק מה זאת עובדה ואיך לנסח בצורה בטוחה שאלה לגבי כל עובדה ולבדוק את אותה עובדה ואז לבדוק את הפלט של השאילתה לגבי אותה עובדה ובהנחה שכל זה עבר בשלום צריך עדיין לזכור שזה מעלה את צריכת המשאבים של המודל מאוד

אגב, בעקבות הפרק האחרון של עושים טכנולוגיה יצא לי לראות את הפוסט של סטיבן וולפראם כאן שבו הוא מסביר בצורה די מפורטת (אם כי יש קצת מתמטיקה וסטטיסטיקה מידי פעם) איך המודלים האלו עובדים, ממליץ בחום (תוודאו שיש לכם כמה שעות פנויות לפני שאתם מתחילים, הוא ארוך בצורה לא נורמלית)

-

היות והדיון נהפך לפילוסופי

אתן זוית נוספת לענייןהמנהג הוא לחפש אותו בשגיאות

ולהציג עד כמה זה עדיין לא מספיק בשלמשום מה אני לא רואה בשום מקום התייחסות הפוכה

כמה הוא כן עוזרכמה מאתנו שנכשלו רחמנא ליצלן

וניסו בסתר לשאול אותו שאלה במקום את גוגל

וקבלו תשובה (מהירה?) ויעילה שהועילה בו במקוםהאם התחליף של חיפוש בגוגל

ושיטוט בין לינקים יותר טוב?

שם אין שטויות?מכירים את זה שהגיע ואמר: האמריקאים זה עם תמים ופתי

וההוכחה: קוראים לי יעקב, ושהגעתי לשם, אמרתי שקוראים לי שלמה - וכולם האמינו לי...זה שהוא עדיין ובעתיד יפלוט שטויות

שבדר"כ ניתן להבינם ולהפריכם די מהר

ניתן להתמודד

כשהוא מציין מחלקה שלא קיימת, אז נכשלת בהעתק-הדבק בודד (מתוך....), נו שויןכך שהשיח לכיוון החיובי

איך ניתן לתשאל אותו נכון

בכדי להגיע לתוצאות נכונות

יהיה יותר יעיל ואפקטיבי -

@ארי כתב בGPT-4 כישוריו בהמצאת תשובות:

@one1010 כתב בGPT-4 כישוריו בהמצאת תשובות:

אבל בלי קשר, זה שלכלב יש 4 רגליים ולא 5 זה כבר נמצא במדע הישן והוא לא צריך להתעדכן דווקא ממידע חדש

אולי זה מגיע מזה שלא על זה הייתה השאלה.

אם תשאל אותו כמה רגליים יש לכלב אני מניח שהוא יודע את התשובה, אבל אם זה חלק זניח מהשאלה הוא פשוט מכניס את הטקסט מהשאלה לתוך התשובה.

כנראה הם חושבים שכך זה יראה יותר אמין כשהוא מתייחס ישירות לשאלה שלך.וזה בדיוק מה ששאלתי למה שלא יעשה בדיקת עובדות גם על השאלה בעצמה כדי למנוע גיחוך

@one1010 כתב בGPT-4 כישוריו בהמצאת תשובות:

וזה בדיוק מה ששאלתי למה שלא יעשה בדיקת עובדות גם על השאלה בעצמה כדי למנוע גיחוך

אני הבנתי שאתה מדבר על שטויות שהוא ממציא אבל הם יכולים להיות אמיתיים, כמו ספריות/פונקציות לא קיימות. על זה אמרתי שזו בעיה קשה

אבל אם אתה מדבר על הדוגמה של @nigun שמדובר בטעות מוכחת שגם המודל תמיד עונה נכון שזו טעות, אני לא רואה סיבה שהם לא יכולים לתכנת אותו שקודם כל הוא יבקר את השאלה ואז ימשיך עם תשובה בהתאם לביקורת על השאלה

-

@one1010 כתב בGPT-4 כישוריו בהמצאת תשובות:

וזה בדיוק מה ששאלתי למה שלא יעשה בדיקת עובדות גם על השאלה בעצמה כדי למנוע גיחוך

אני הבנתי שאתה מדבר על שטויות שהוא ממציא אבל הם יכולים להיות אמיתיים, כמו ספריות/פונקציות לא קיימות. על זה אמרתי שזו בעיה קשה

אבל אם אתה מדבר על הדוגמה של @nigun שמדובר בטעות מוכחת שגם המודל תמיד עונה נכון שזו טעות, אני לא רואה סיבה שהם לא יכולים לתכנת אותו שקודם כל הוא יבקר את השאלה ואז ימשיך עם תשובה בהתאם לביקורת על השאלה

@yossiz כתב בGPT-4 כישוריו בהמצאת תשובות:

אבל אם אתה מדבר על הדוגמה של @nigun שמדובר בטעות מוכחת שגם המודל תמיד עונה נכון שזו טעות, אני לא רואה סיבה שהם לא יכולים לתכנת אותו שקודם כל הוא יבקר את השאלה ואז ימשיך עם תשובה בהתאם לביקורת על השאלה

כן, על זה דיברתי

-

@one1010 כתב בGPT-4 כישוריו בהמצאת תשובות:

וזה בדיוק מה ששאלתי למה שלא יעשה בדיקת עובדות גם על השאלה בעצמה כדי למנוע גיחוך

אני הבנתי שאתה מדבר על שטויות שהוא ממציא אבל הם יכולים להיות אמיתיים, כמו ספריות/פונקציות לא קיימות. על זה אמרתי שזו בעיה קשה

אבל אם אתה מדבר על הדוגמה של @nigun שמדובר בטעות מוכחת שגם המודל תמיד עונה נכון שזו טעות, אני לא רואה סיבה שהם לא יכולים לתכנת אותו שקודם כל הוא יבקר את השאלה ואז ימשיך עם תשובה בהתאם לביקורת על השאלה

@yossiz כתב בGPT-4 כישוריו בהמצאת תשובות:

אבל אם אתה מדבר על הדוגמה של @nigun שמדובר בטעות מוכחת שגם המודל תמיד עונה נכון שזו טעות, אני לא רואה סיבה שהם לא יכולים לתכנת אותו שקודם כל הוא יבקר את השאלה ואז ימשיך עם תשובה בהתאם לביקורת על השאלה

איך אפשר לבחון שאלה?

לשלוח פרומפט מיוחד ששואל האם השאלה מכילה תוכן שגוי?

-

@nigun באמת מעניין, הייתי מצפה למשהו יותר חכם

גם אני ניסיתי (גירסה 3.5) והוא הצליח רק בקושי לעלות על טעותו, אחרי שנתתי לו רמז

@yossiz

אני לא ציפיתי למשהו יותר חכם.

זה סך הכל מודל שפה, ואין הרבה טקסט באינטרנט שמסביר שלחתול יש 4 רגליים (כי זה מובן מאליו)

ולכן כל מידע שלא כתוב עליו בטקסט עליו הוא אומן משהוא מפורש, אין לו מספיק הסתברות לומר שזה לא נכון.לגבי ספריות לא קיימות אפשר לחבר אותו לאינטרנט שיבדוק האם הספריה קיימת, אבל קוד שלא עובד זה קצת יותר מסובך, יחברו אותו לVM?

אם תשאל אותו האם הקוד הזה יעבוד, יתכן שהוא יענה שכן כי אין לו טקסט מפורש שמסביר שזה לא יעבוד בגלל X.